Не секрет, що пошукові системи борються з плагіатом, ратуючи за унікальність контенту, розміщеного на сторінках сайтів в Інтернеті. Біржі копірайтингу, тому і затребувані, що без унікального контенту не обійтися. Будь-який зареєстрований в пошуковій системі може бути видалений з індексації, якщо розміщений на ньому не унікальний контент.

Ніхто не хоче опинитися в аутсайдерах, тому багато хто прагне використовувати обхідні шляхи. Протиборство розробників алгоритмів пошукової оптимізації для пошукових систем і «чорних» оптимізаторів зі своїми сателітами, постійно перебувають у протистоянні. У цьому прагненні хто – кого, зуміє вивести на «чисту воду», чи, навпаки занурити в бруд, відбувається змагання протиборчих сил. Поки що повної і остаточної перемоги не зафіксовано ні за однією стороною.

Як пошукові системи визначають неунікальний контент? З набору ключових слів виділяються канонічні форми слів, а з комбінації цих форм будуються сигнатурні набори. Переробивши будь-який контент, набирається хеш-таблиця з сигнатур, на основі розміщеного матеріалу. А суть хеш-таблиць, які застосовуються для асоціативного пошуку, тут задіюється і для пошуку найбільш релевантної інформації по пошуковим запитам, і для «обчислення» неунікального контенту.

Що роблять біржі копірайтингу і торгівлі посиланнями під розміщення реклами, їм теж потрібні аналогічні механізми, для визначення унікальності контенту розміщується на продаж, або розміщується в біржі посилань. Та нічого складного біржі для цього не використовують, доки пошук в пошукових системах поки що безкоштовний, хоча пошуковики могли б і «банити» сайти подібного роду і мати з цього гроші, але що є, то і «юзають», як говориться.

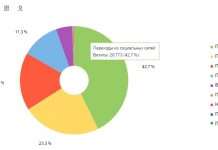

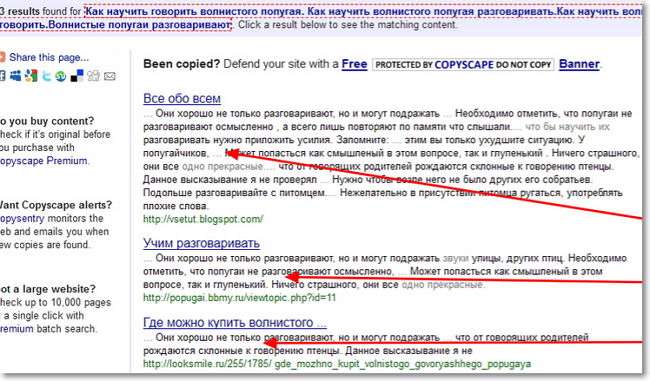

Використовуючи пошук в пошукових системах, біржі текстового контенту, не використовують понад складних алгоритмів. Навіщо мудрувати, коли більшу частину роботи можуть провести і самі пошукові системи? Аналіз тексту за відповідністю пошуковому запиту, розбір фраз і синтаксичний з морфологічним аналізом вони (пошукові системи) вміють робити і непогано з цим справляються. Контент розміщується і «згодовується» у будь-якому випадку тим же пошуковим системам, в даний момент не заглиблюємося в суть затребуваності контенту самою людиною, для якого все це і розміщується в Інтернеті, але тут розглядаються механізми обробки інформації.

Тим, кому необхідно перевірити будь-який текст на унікальність, достатньо розбити текст, що перевіряється, на фрази від п’яти послідовних слів і видати запити відомі пошукові системи. По відгуку пошукових систем, можна аналізувати, зустрічаються такі фрази в Інтернеті.

Не складно автоматизується прийняття рішення, для цього варто копнути трохи глибше. Відгук пошукача, який вже провів попередню підготовку і виділив жирним шрифтом шукані слова фраз, треба обіграти. Що це означає? А те, що в самому HTML-тексті, відповідні фрази вже «виділені» і залишається тільки скористатися цими прапорами в програмі, щоб за кількістю прапорів приймати рішення про унікальність контенту.

Хто засумнівається в правильності функціонування моделі, нехай згадає, коли йому видавали біржі в результаті перевірки, що виявлена не унікальність тексту, тобто запозичення або плагіат. Часто образливо звучить, таке звинувачення, тому що «набитих» фраз, зустрічається де завгодно і скільки завгодно. Особливо загрожує цитування відомих особистостей і анекдотичні і фраз з «летючими» висловами і крилатими виразами.

Тим ні менш недосконалість таких підходів ніхто не може заперечувати, результати перевірок на унікальність визнаються непорушними. Хто не згоден, той може відмовитися від запропонованих оферт і не більше того. Інших юридичних норм на цей рахунок не поширюється. Хто платить, той і править справою. Алгоритми перевірки змінюють, списки ключових і стоп слів коригуються, але витрати залишаються неминучими.

Копірайтери намагаються відходити від набитих фраз, унікальність контенту диктує такі норми, що стиль письма доводиться підлаштовувати під передбачувані результати перевірок на унікальність тексту. Тому варто поспівчувати і зрозуміти, що відсутність зв’язного мовлення часто народжується всупереч літературному стилю і навіть здоровому глузду!

Знаючи механізми перевірки на унікальність, «чорні» оптимізатори давно вже змирилися з тим, що необхідно перебудовуватися і підлаштовуватися під нові правила гри. Дорвеї і сателіти швидко «вираховують» пошуковими системами, тому сили зосереджують на генерації контенту з використанням ланцюгів Макарова, застосовують різного роду програмні рішення, наприклад, як «Бредогон» і йому подібні.

Сайти для людей і дорвеї заповнюють контентом генератори на основі ланцюгів Макарова, текстівки виходять не читаються, для людини, але пошукові системи це «проковтують», поки «проковтують». Робота над цими генераторами нісенітниці ведеться, тими ж аналізаторами тексту. Але бірж, які торгують контентом турбуватися не про що, це «головний біль» розробників алгоритмів аналізу і пошуку самих пошукових систем.